핵심 요약

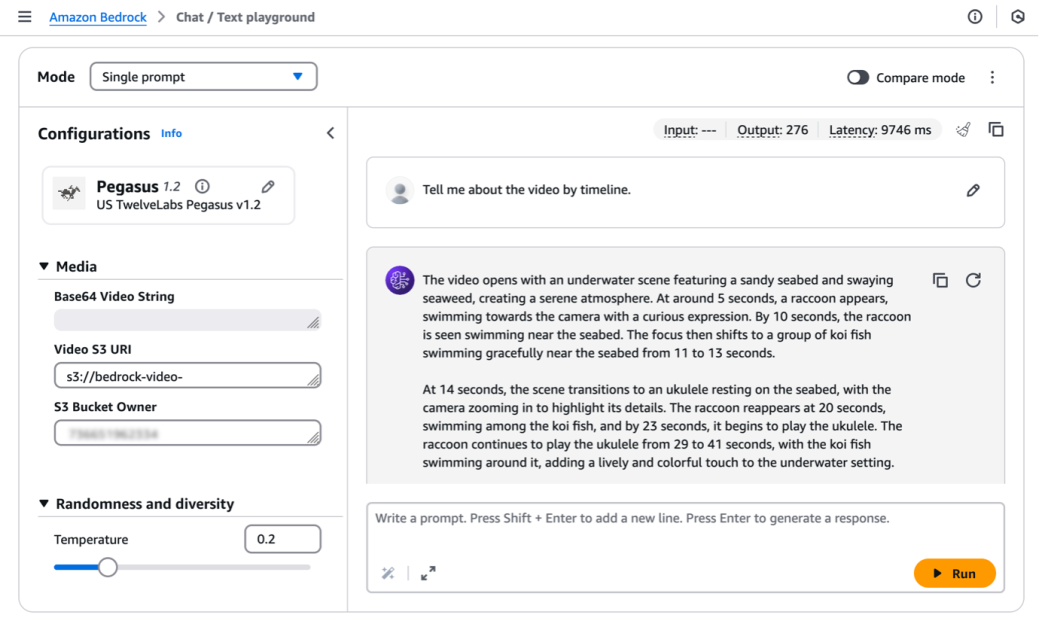

AWS가 TwelveLabs Marengo를 활용해 Amazon Bedrock에서 비디오 이해를 위한 멀티모달 임베딩 및 시맨틱 검색 솔루션을 구현하고, OpenSearch Serverless를 활용한 엔드투엔드 파이프라인을 제시했습니다.

구현 방법

- TwelveLabs Marengo-Embed 3.0의 다중 벡터 아키텍처로 비디오의 시각(visual), 전사(transcription), 오디오(audio) 임베딩을 각각 생성

- Amazon Bedrock의 동기식 추론으로 비디오 임베딩 생성 및 280개 세그먼트 단위의 시간 기반 임베딩 제공

- 결과를 S3에 저장하고, 비디오 임베딩 타입(visual, transcription, audio)별로 세그먼트 정보를 포함하는 출력 구성

- OpenSearch Serverless 컬렉션 생성 및 벡터 인덱스( dense_vector, 차원 1024, 코사인 유사도) 정의

- 임베딩 결과를 OpenSearch에 벌크 인덱싱하여 시맨틱 검색 가능하도록 구성

- 텍스트, 이미지, 오디오 등 교차 모달 쿼리로 시맨틱 검색 수행 시나리오 시연

- 실시간 텍스트·이미지 처리 지원 기능 및 다중 모달 임베딩의 활용 예시 제시

- 전체 코드 샘플은 GitHub 저장소에 공개된 예제를 참조하도록 안내

주요 결과

- 단일 Bedrock API 호출로 비디오를 336개의 검색 가능한 세그먼트로 분할하고 각 세그먼트에 대해 visual, transcription, audio 임베딩을 생성

- 멀티 모달 벡터를 이용한 교차 모달 검색으로 텍스트/이미지/오디오 쿼리에 대한 정밀한 콘텐츠 탐색 가능

- OpenSearch Serverless 벡터 인덱스를 구성해 대규모 비디오 데이터에 대한 확장성과 빠른 검색 제공

- Marengo 3.0의 동기식 추론으로 실시간 텍스트·이미지 처리 지원 및 고도화된 비디오 이해 가능